水冷GPUサーバーとは?なぜ今、注目されるのか

近年、生成AI(人工知能)やHPC(High Performance Computing:高性能計算)の進化が目覚ましく、私たちの生活やビジネスに大きな変革をもたらしています。これらの技術を支えるのが、GPU(Graphics Processing Unit)を搭載した高性能なサーバーです。GPUは膨大な計算を高速で処理できるため、AIの学習や複雑なシミュレーションに不可欠な存在となっています。

しかし、高性能であるゆえに、GPUサーバーは大量の熱を発生させます。この熱を効率的に冷却できなければ、サーバーの性能が十分に発揮できなかったり、故障の原因になったりする可能性があります。これまでのデータセンターでは、主に空冷(空気で冷やす方法)が用いられてきましたが、GPUの性能向上に伴い、空冷だけでは対応しきれない状況が生まれてきました。

そこで注目されているのが「水冷GPUサーバー」です。水冷は空気よりもはるかに効率的に熱を伝えることができるため、GPUをより低温で安定して稼働させることが可能になります。これにより、GPUの性能を最大限に引き出し、システムの安定性を高めることができるのです。海外では水冷GPUサーバーの商用利用が増加していますが、国内ではまだ事例が少ないのが現状でした。

国内での課題を解決!NTTPCらがPoCに成功

このような背景の中、NTTPCコミュニケーションズ株式会社(以下、NTTPC)、株式会社ゲットワークス(以下、ゲットワークス)、株式会社フィックスターズ(以下、フィックスターズ)の3社が共同で、水冷GPUサーバーの効果的な運用を目指したPoC(概念実証:新しい技術やアイデアが実現可能かどうかを検証する取り組み)を実施しました。

このPoCの目的は、高性能なGPUサーバーを最大限に活用するために必要な「データセンター」「GPUサーバー」「ソフトウェア」の各要素を統合的に連携させ、運用効率を向上させることでした。これまでは、これらの要素が個別に最適化されるに留まるケースが多く、水冷GPUサーバー本来の能力を発揮しきれていないという課題があったのです。

コンテナ型データセンターの活用

今回のPoCでは、特に「コンテナ型データセンター」が活用されました。コンテナ型データセンターとは、サーバーや冷却設備などをコンテナに収めた移動可能なデータセンターのことです。これにより、必要な場所に迅速かつ柔軟にデータセンター環境を構築できるという大きなメリットがあります。

ゲットワークスが提供する新潟県越後湯沢の「湯沢GXデータセンター」にある20フィートタイプのコンテナ型データセンターが検証環境として使われました。この環境下で、水冷GPUサーバーの実機を稼働させ、様々な負荷を与えながらデータセンター、GPUサーバー、ソフトウェアの統合的な調整が行われました。

驚異の電力効率「pPUE1.114」を記録!

今回のPoCで最も注目すべき成果は、コンテナ型データセンターにおいて水冷GPUサーバーが「pPUE1.114」という優れた電力効率を記録したことです。AI初心者の方には聞き慣れない言葉かもしれませんが、pPUEはデータセンターの一部(モジュールやゾーン)の電力効率を示す重要な指標です。

pPUEとは?

pPUE(partial Power Usage Effectiveness)は、「ICT機器の消費電力」に対する「特定部分の総消費電力(ICT機器の消費電力+冷却設備や照明などの消費電力)」の比率で表されます。PUEが施設全体の電力効率を示すのに対し、pPUEはより限定された範囲の効率を示すものです。

一般的に、最新の水冷式大規模データセンターでもPUEは1.05~1.2程度とされており、pPUEの値が1.1前後であれば非常に優秀であると評価されます。今回の「1.114」という数値は、大規模データセンター以外では実現が難しいとされる高い電力効率の範囲内であり、コンテナ型データセンターでの水冷GPUサーバーの商用利用の有効性を明確に示しています。

検証で明らかになった具体的な効果

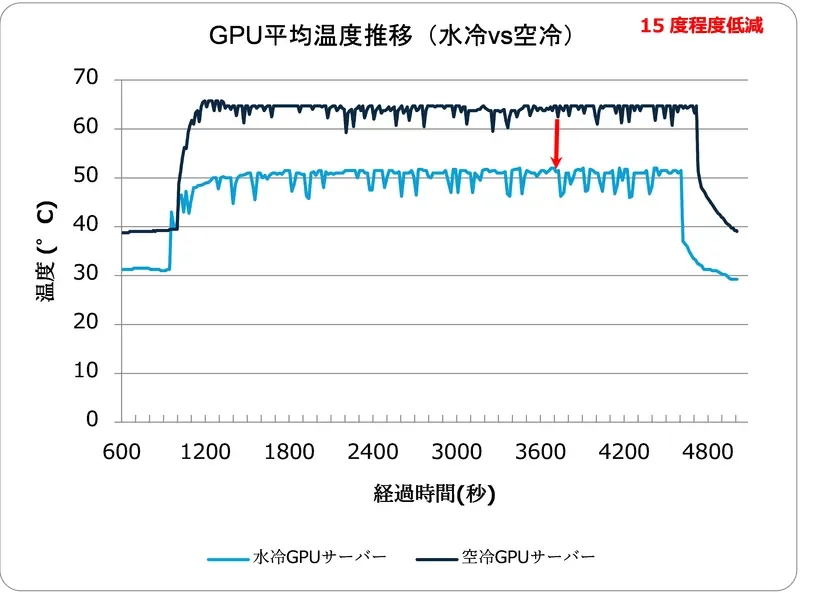

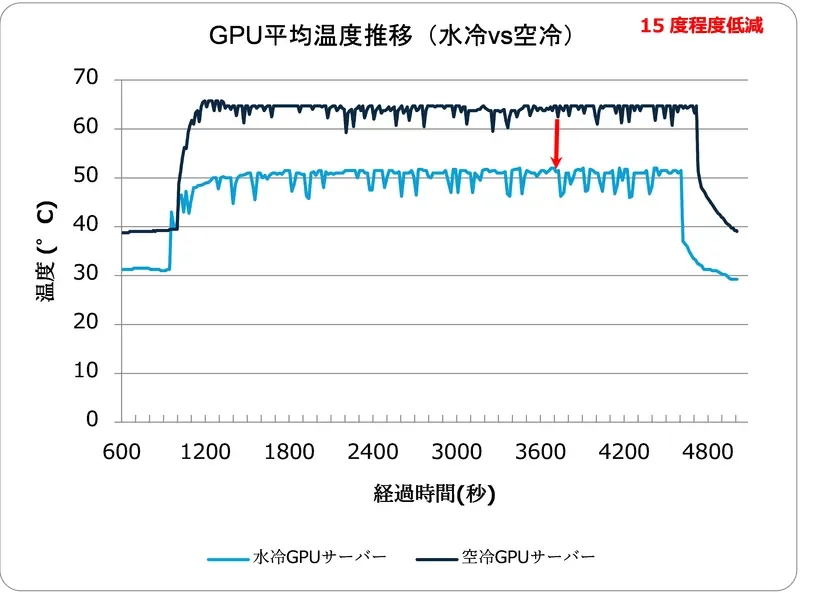

PoCでは、電力効率の向上だけでなく、水冷GPUサーバーの具体的な冷却効果も確認されました。水冷GPUサーバーと空冷GPUサーバーの性能を比較した結果、最大負荷時においてGPUの平均温度が約15度低減されることが実証されました。これは、CDU(冷却分配装置)などの冷却設備が適切に機能していることを示しています。

さらに、サーバーの負荷と温度をリアルタイムで監視し、InRow空調(サーバーラックの列の間に設置する局所空調システム)の制御や、キャッピング(冷気と排熱を効率的に分離する仕切りや構造設計)を実施することで、冷却効率を最大化しました。これらの取り組みにより、pPUEなどの電力使用効率を統合的に収集・管理するシステムが構築され、運用効率の最大化が実現できたのです。

今回の検証レポートは、以下のURLから詳細をご覧いただけます。

3社の専門性が生んだ協業の成果

今回のPoCの成功は、NTTPC、ゲットワークス、フィックスターズそれぞれの専門性と技術力が結集した結果と言えるでしょう。

NTTPCの役割

NTTPCは、これまで大規模GPUクラスターの提供実績を豊富に持ち、その経験に基づいたハードウェアエンジニアリングの観点から今回の検証を実施しました。AI関連事業やデータセンター事業に積極的に取り組んでおり、NVIDIA Partner Network Award 2025で国内最高のアワードを受賞するなど、GPU基盤構築における高い技術力と知見を持っています。

ゲットワークスの役割

ゲットワークスは、コンテナ型データセンターのパイオニアとして、2013年から様々な実証実験を重ねてきました。今回のPoCでは、商用環境と同等の20フィートタイプのコンテナ型データセンター1棟を提供し、キャッピングなどの調整を通じて最適なサーバー稼働環境を構築しました。同社は、省エネや再生可能エネルギーの活用にも力を入れており、多様なニーズに応じたデータセンター構築の実績を多数持っています。

フィックスターズの役割

フィックスターズは、「Speed up your AI」をコーポレートメッセージに掲げるテクノロジーカンパニーです。今回のPoCでは、水冷GPUサーバーとサーバー冷却設備を実証実験用に提供したほか、コンテナ型データセンター内の環境、ハードウェア、ソフトウェアを統合的に管理するモニタリングツールを構築しました。AIモデルの高速化技術に強みを持ち、様々な分野で次世代AI技術の進化を推進しています。

今後の展望:国内水冷GPUサーバーの普及へ

今回のPoCの成功は、高性能なGPUサーバーの需要が今後さらに拡大する中で、国内における水冷GPUサーバーのニーズに応える大きな一歩となります。3社は今後も連携を強化し、日本国内でのコンテナ型データセンターを活用した水冷GPUサーバーの商用利用拡大に向けて取り組んでいくとのことです。

生成AIやHPCの本格的な活用が進むにつれて、GPUサーバーの性能はますます重要になります。水冷技術の導入は、その性能を最大限に引き出し、安定した運用を実現するための鍵となるでしょう。今回の成果は、国内のAIインフラが新たな段階に進むための重要なマイルストーンであり、今後の発展に大いに期待が寄せられます。

まとめ

NTTPCコミュニケーションズ、ゲットワークス、フィックスターズの3社は、コンテナ型データセンターにおける水冷GPUサーバーの運用効率向上に関するPoCに成功しました。この検証では、水冷GPUサーバーが空冷よりも約15度低い温度で安定稼働し、pPUE1.114という優れた電力効率を達成しました。これは、国内での水冷GPUサーバーの商用利用に向けた大きな進展であり、生成AIやHPCの発展を支える重要な技術革新と言えるでしょう。

AI技術の進化とともに、その基盤となるデータセンターのあり方も変化しています。今回の成果は、高まる計算需要に対応しつつ、環境負荷の低減にも貢献する持続可能なAIインフラの実現に向けた、具体的な道筋を示すものとなるでしょう。今後、国内で水冷GPUサーバーが普及し、より高性能で効率的なAI活用が進むことに期待が集まります。