GPU不要!ノートPCで「Wikipedia300万件」を高速推論する革新的AI「CompreSeed AI」が登場!AIの常識を覆す技術を徹底解説

近年、AI(人工知能)の進化は目覚ましく、私たちの生活やビジネスに欠かせない存在となりつつあります。しかし、高性能なAIを動かすためには、GPU(Graphics Processing Unit)と呼ばれる特殊な計算装置が不可欠とされてきました。GPUは高速な並列計算を可能にするため、AIの複雑な処理には必須の存在ですが、その導入には高額なコストがかかり、また消費電力も大きいため、誰もが気軽にAIを利用できるわけではありませんでした。

このような課題に対し、株式会社アイテックが画期的な解決策を提示しました。それが、GPUを一切使用せず、なんと一般的なノートPCで大規模な知識を高速に推論できる新技術「圧縮検索推論AI」こと「CompreSeed AI」です。この技術は、AIの世界に新たな可能性をもたらす「第三の方式」として注目を集めています。

GPU不要でAIが動く!画期的な「CompreSeed AI」とは?

CompreSeed AIの最大の特徴は、その名の通り「GPUを必要としない」点にあります。これまでの多くのAI、特に大規模なデータから情報を検索したり、文章を生成したりするAIは、数百次元にも及ぶ複雑なベクトル演算を行うために、強力なGPUを搭載した高性能なコンピュータが必須でした。これにより、AIの導入には以下のような問題が生じていました。

-

GPUコストが高い: 高性能なGPUは非常に高価であり、導入費用が大きな負担となることがありました。

-

ベクトル展開でメモリ消費が大きい: データを処理する際に、圧縮された状態から展開(解凍)する必要があり、大量のメモリを消費していました。

-

中小企業・自治体が導入しづらい: 上記のコストや技術的なハードルの高さから、予算やリソースが限られる中小企業や地方自治体では、AIの導入が難しい状況でした。

CompreSeed AIは、これらの課題を根本から解決するために開発されました。このAIは、データを「展開せずに」圧縮された状態のまま検索・推論を行うという、世界初のAI構造を採用しています。これにより、CPUのみで大規模な知識検索が可能となり、AI計算コストを従来の1/50から1/70にまで大幅に削減できるとされています。

なぜGPUが不要なのか?「圧縮検索推論AI」の仕組みを徹底解説

CompreSeed AIがGPUなしで動作する秘密は、その独自の「圧縮検索推論」の仕組みにあります。従来のAI技術、例えば「ベクトル検索」と呼ばれる手法では、膨大なテキストデータなどを数値の羅列(ベクトル)に変換し、似た意味を持つベクトル同士が近くに配置されるように処理します。このベクトルを作成する過程や、大量のベクトルの中から関連性の高いものを探し出す過程で、GPUの高速な並列計算能力が不可欠でした。

一方、CompreSeed AIは、データを「意味的圧縮構造(semantic_index)」という独自の形式で保存します。この構造は、たとえるなら、本の内容を要点だけを抽出して、さらにその要点同士の関連性も効率的に整理して収納するようなイメージです。これにより、AIはデータをわざわざ展開して巨大なベクトルに変換することなく、圧縮された状態のまま直接意味を検索し、推論を行うことができます。

この「データを展開しない」というアプローチにより、CompreSeed AIは以下のメリットを実現しています。

-

圧縮状態のまま検索・推論: データ展開の処理が不要になるため、計算負荷が大幅に軽減されます。

-

ベクトル展開不要: 従来のAIで必要だった大量のメモリを消費するベクトル展開が不要になります。

-

CPUのみで大規模知識検索: 高価なGPUに頼ることなく、一般的なPCに搭載されているCPUだけで大規模な知識ベースを扱うことができます。

-

応答速度 0.2〜0.8秒: 圧縮状態での処理は非常に効率的で、驚異的な速さで結果を導き出します。

この革新的な仕組みにより、AIの利用にかかるハードルが劇的に下がり、より多くの場所でAIが活用される未来が期待されます。

一般ノートPCで実現!驚きの実機検証結果

CompreSeed AIの性能は、実際のノートPCでの検証によっても証明されています。株式会社アイテックが行った検証では、一般的な家庭向けモデルであるNEC Lavie NS150(GPU非搭載、RAM 8〜16GB、OS Windows 11)を使用し、PythonとFlask UIの環境でCompreSeed AIを稼働させました。

知識データとして使用されたのは、なんとWikipediaの300万件もの記事です。この膨大なデータは、CompreSeed AIによってわずか1.8GBに圧縮されました。そして、この環境下での推論結果は以下の通りです。

-

応答速度: 0.2〜0.8秒

-

メモリ使用量: 2〜3GB

-

安定稼働: 長時間でも負荷が低い

これは、従来のAIでは考えられなかった驚異的な結果です。一般的なノートPCで、これほど大量の知識を瞬時に、かつ低負荷で処理できることは、まさに「AIの民主化」を象徴する出来事と言えるでしょう。

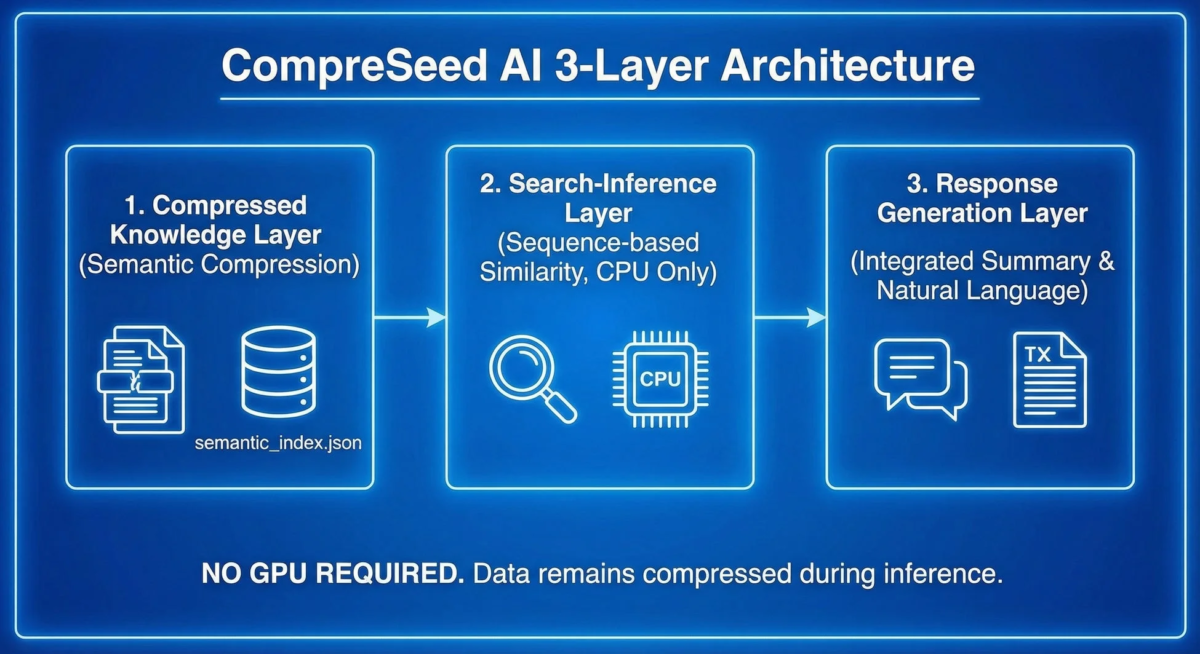

高速・軽量化を支える「3層アーキテクチャ」

CompreSeed AIの高速かつ軽量な動作は、その独自の「3層アーキテクチャ」によって実現されています。このアーキテクチャは、それぞれの層が特定の役割を担うことで、効率的な情報処理を可能にしています。

-

圧縮知識層(Semantic Compression Layer):

この層では、大量の文書データが「意味単位」で圧縮され、「semantic_index.json」というファイルに格納されます。ここで、データの意味的な特徴が効率的に捉えられ、後の検索・推論に最適な形で準備されます。 -

検索・推論層(Search-Inference Layer):

この層がCompreSeed AIの心臓部と言えるでしょう。ユーザーからの問い合わせに対し、「Sequence-based Similarity」という独自の手法を用いて、GPUなしで意味的な類似度を推定します。これにより、圧縮された知識の中から、関連性の高い情報を高速に探し出すことが可能です。 -

応答生成層(Response Generation Layer):

検索・推論層で見つけ出された情報をもとに、圧縮された要約を統合し、人間が理解しやすい自然な文章で回答を生成します。また、この層はChatGPTなどの外部LLM(大規模言語モデル)と接続することも可能であり、より高度な対話や情報生成にも対応できる柔軟性を持っています。

この3層構造により、CompreSeed AIはデータの準備から回答の生成までを一貫して効率的に行うことができます。

従来のAI技術との比較:CompreSeed AIの優位性

CompreSeed AIの革新性は、従来の一般的なAI技術と比較することでより明確になります。例えば、FAISSのようなベクトル検索とEmbedding方式を用いたAIと比較すると、以下の点で大きな優位性があることが示されています。

-

データ展開: 従来のベクトル検索ではデータ展開が必須でしたが、CompreSeed AIでは不要です。

-

必要GPU: 従来のベクトル検索ではGPUが必要でしたが、CompreSeed AIでは一切不要です。

-

応答速度: 従来の2〜4秒に対し、CompreSeed AIは0.2〜0.8秒と格段に高速です。

-

メモリ消費: 従来は大量のメモリを消費しましたが、CompreSeed AIは1/8程度の少ないメモリで動作します。

-

コスト: AI計算コストは従来の1/50〜1/70に削減されます。

-

知識更新: 従来のAIでは知識を更新する際に再学習が必要でしたが、CompreSeed AIでは部分的な更新が可能です。

これらの比較から、CompreSeed AIがGPU不要というだけでなく、速度、効率性、コストの面で非常に優れた性能を持っていることがわかります。

幅広い応用領域:CompreSeed AIが変える未来

CompreSeed AIの登場は、これまでAIの導入が難しかった様々な分野に新たな可能性をもたらします。その応用領域は非常に広く、すぐに導入できる実用的なものばかりです。

-

自治体向け問い合わせAI: 市民からの多岐にわたる問い合わせに対し、迅速かつ正確な情報を提供できます。これにより、窓口業務の負担軽減や市民サービスの向上が期待されます。

-

教育:学習参考書型AI: 学生が教科書や参考書の内容について質問すると、AIが即座に理解度に応じた解説や追加情報を提供します。個別最適化された学習支援が可能になります。

-

医療:症例知識検索: 医師や看護師が患者の症例について検索すると、膨大な医療データの中から関連性の高い情報や過去の類似症例を素早く提示します。診断支援や治療方針の決定に役立ちます。

-

法務:条文・判例検索: 弁護士や法律関係者が特定の条文や判例について検索すると、複雑な法律文書の中から必要な情報を効率的に見つけ出します。調査時間の短縮と業務効率化に貢献します。

-

企業内ナレッジ統合: 社内に散在するマニュアル、報告書、過去のプロジェクトデータなどを一元的に管理し、社員が必要な情報をいつでも引き出せるようにします。新入社員のオンボーディングや業務知識の共有が容易になります。

-

オフライン環境下のAIシステム: インターネット接続が不安定な場所や、セキュリティ上の理由から外部ネットワークへの接続が制限される環境でも、CompreSeed AIはローカルで動作するため、安心して大規模なAIシステムを導入できます。これにより、機密情報を扱う現場での「ローカル大規模AI」の実現が可能になります。

これらの応用例は、CompreSeed AIが社会の様々な課題を解決し、よりスマートで効率的な未来を築くための強力なツールとなることを示しています。

技術の透明性:ホワイトペーパーで詳細を公開

株式会社アイテックは、CompreSeed AIの技術的な詳細と再現手順をまとめた15ページのホワイトペーパーを公開しています。このホワイトペーパーには、以下のような内容が詳しく記載されています。

-

圧縮推論アルゴリズム

-

類似度計算モデル

-

再構築手順

-

実機検証結果

-

API連携構造

-

評価方法

-

再現プロトコル(Replication Protocol)

このように技術の詳細を公開することで、研究者や企業が自由にCompreSeed AIを検証し、さらなる発展に貢献できる環境を提供しています。これは、技術の透明性を重視し、オープンイノベーションを促進しようとする株式会社アイテックの姿勢を示すものです。

今後の展望:さらなる進化へ

CompreSeed AIは、すでに国内で特許を出願しており、今後は海外への出願(PCT)も準備を進めています。また、企業や自治体向けのPoC(概念実証)を開始し、実際の現場での導入を推進していくとのことです。さらに、API版CompreSeedの公開も準備されており、より多くの開発者や企業がこの革新的な技術を利用できるようになるでしょう。

まとめ

株式会社アイテックが公開した「圧縮検索推論AI」CompreSeed AIは、GPU不要で一般のノートPCでも大規模知識を高速に推論できる、まさにAIの常識を覆す画期的な技術です。高コストやメモリ消費、導入の難しさといった従来のAIが抱える課題を解決し、AI計算コストを大幅に削減することで、より多くの人々や組織がAIの恩恵を受けられるようになります。

自治体、教育、医療、法務、企業内ナレッジ統合、そしてオフライン環境下での利用など、その応用範囲は無限大です。技術詳細が公開されたホワイトペーパーは、この技術が持つ可能性をさらに広げることでしょう。CompreSeed AIが、AIがより身近で使いやすい存在となる未来を切り開いていくことに期待が高まります。