AI(人工知能)技術の進化は目覚ましく、私たちの生活やビジネスに大きな変革をもたらしています。そのAIを支える基盤技術の一つが、HPC(High Performance Computing)、つまり高性能計算です。このHPCとAIが融合することで、これまでにないスピードと規模で複雑な問題を解決できるようになります。

2026年1月26日(月曜日)から29日(木曜日)にかけて、大阪府立国際会議場(グランキューブ大阪)で開催される国際会議「SCA/HPCAsia 2026」では、このAIとHPCの最先端が披露されます。特に注目されるのが、コアマイクロシステムズ株式会社(以下、コアマイクロシステムズ)による革新的な次世代AI HPCソリューションの発表です。同社はPlatinumスポンサーとして協賛し、出展と講演を通じて、AIインテンシブな時代におけるグリッド&マルチクラウド対応の次世代Disaggregated型スーパーコンピューティングと、大規模スケールアウトHPC戦略を提案します。

AI時代のスーパーコンピューティングとは?

まず、「HPC」とは何か、そしてなぜAI時代にHPCが重要になるのかを、AI初心者の方にも分かりやすく説明します。

HPC(High Performance Computing)は、「高性能計算」と訳され、大量のデータを非常に速く処理するための技術やシステムの総称です。私たちが普段使っているパソコンが1秒間に処理できる計算量とは比べ物にならないほどの膨大な計算を、同時に、そして高速に行うことができます。スーパーコンピューターもこのHPCの一種であり、気象予測、新薬開発、宇宙科学の研究、自動車の衝突シミュレーションなど、複雑で大規模な計算が必要な様々な分野で不可欠な存在です。

近年、AI、特にディープラーニング(深層学習)の発展は目覚ましく、その学習や推論には途方もない量のデータと計算能力が求められます。AIモデルを訓練するには、数テラバイト、時にはペタバイト級のデータを処理し、数百万、数千万回の計算を繰り返す必要があります。このような計算負荷の高いAI処理を効率的に実行するためには、従来のHPCシステムだけでは不十分になってきています。そこで、AIの特性に合わせて最適化された「AI HPC」という概念が生まれました。

「AIインテンシブな時代」とは、AIがあらゆる産業や社会の基盤となり、AI技術の活用がビジネスや研究開発の中心となる時代を指します。この時代において、HPCはAIの性能を最大限に引き出し、新たな発見やイノベーションを加速させるための「エンジン」としての役割を担います。コアマイクロシステムズが提案する次世代AI HPCソリューションは、まさにこのAIインテンシブな時代に対応し、AIの可能性を広げるための重要な鍵となります。

ランチスピーカーセッション:革新のAI HPCソリューション

「SCA/HPCAsia 2026」のランチスピーカーセッションでは、「AIインテンシブな先進のスーパーコンピューティングを可能にする革新のAI HPCソリューション」と題し、コアマイクロシステムズが具体的な戦略と技術を発表します。このセッションは、2026年1月27日(火曜日)12:30から13:30まで、10階の1002号室で開催され、ランチを楽しみながら自由に観覧できます。

講演は3部構成で、それぞれ異なる側面からAI HPCの未来を形作る戦略的なソリューションが紹介されます。

1. Disaggregated Scale-out AI HPCパイプラインストレージソリューション

このセッションでは、Xinnor CEOのDmitry Livshits氏とTsuyoshi Okawa氏が講演を行います。

「Disaggregated(ディスアグリゲーテッド)」とは、「分離された」という意味です。従来のコンピューターシステムでは、CPU(中央演算処理装置)、メモリ、ストレージといった構成要素が一つのサーバーにまとまっていました。しかし、Disaggregated型システムでは、これらの要素を物理的に分離し、必要に応じて柔軟に組み合わせることを可能にします。これにより、特定の要素だけを増強したり、異なる種類の要素を組み合わせたりといった柔軟な運用が可能になり、AIワークロードに最適な環境を構築しやすくなります。

「Scale-out(スケールアウト)」は、処理能力を向上させるために、サーバーの数を増やしていく手法です。AIの学習では膨大なデータを扱うため、複数のストレージシステムを連携させて容量や性能を拡張していく必要があります。このソリューションは、AIのデータ処理パイプライン(データの入力から処理、出力までの一連の流れ)において、ストレージのボトルネックを解消し、高速かつ効率的なデータアクセスを実現することを目指しています。

2. Grid Scale-out AI HPCモジュラープラットフォーム&データセンタソリューション

Kazuhiro Hirano氏が講演するこのセッションでは、「Grid(グリッド)」と「モジュラープラットフォーム」という概念が中心となります。

「グリッド」とは、複数のコンピューターやデータセンターをネットワークで連結し、あたかも一つの巨大なコンピューターであるかのように利用する技術です。これにより、地理的に分散したHPCリソースを効率的に活用し、大規模なAI計算を可能にします。

「モジュラープラットフォーム」とは、あらかじめ機能ごとに分割された「モジュール」を組み合わせてシステムを構築する方式です。データセンターの建設において、必要な機能(計算モジュール、ストレージモジュール、冷却モジュールなど)をブロックのように組み合わせることで、建設期間の短縮やコスト削減、将来的な拡張性の向上を実現します。このソリューションは、AI HPCデータセンターの構築と運用をよりシンプルかつ効率的にすることを目指しています。

3. Global Multi-cloud AI HPCリソースオーケストレーションソリューション

Chiaki Nishikawa氏によるこのセッションでは、「マルチクラウド」と「リソースオーケストレーション」が焦点となります。

「マルチクラウド」とは、Amazon Web Services(AWS)、Microsoft Azure、Google Cloud Platform(GCP)など、複数のクラウドサービスを組み合わせて利用することです。それぞれのクラウドサービスには得意な分野や料金体系の違いがあるため、AIワークロードの特性やコスト、データの所在地などに応じて最適なクラウドを使い分けることで、効率的で柔軟なAI開発環境を構築できます。

「リソースオーケストレーション」とは、これらの分散したクラウドやオンプレミス(自社保有の設備)のHPCリソースを、自動的かつ最適に管理・調整する技術です。どの計算リソースをどのAIジョブに割り当てるか、ストレージはどこに配置するかなどを、システムが自動で判断し、最適なパフォーマンスとコスト効率を実現します。これにより、AI開発者はインフラ管理の手間から解放され、AIモデルの開発に集中できるようになります。

これらのソリューションは、AI開発者が直面する計算リソースの不足、データ管理の複雑さ、コストの増大といった課題に対し、包括的な解決策を提示するものと言えるでしょう。

エキシビターズフォーラム:次世代データセンター開発の鍵

AI HPCデータセンターの建設は、高度な統合化と同時に、コスト削減と工期短縮が大きな課題です。コアマイクロシステムズは、この課題に対する革新的なソリューションをExhibitors Forum(エキシビターズフォーラム)で発表します。講演は2026年1月29日(木曜日)11:40から11:55まで、3階の展示会場内フォーラムエリアで行われ、Hiroki Sakamoto氏が「次世代ダイナミックスケールアウトコンテナ型 統合AI HPCデータセンタの開発」について説明します。

同社が提案するのは、国際特許出願済みの「通路連結拡張コンテナ技術」を基盤とした、建設導入工事がほぼ不要となる「完全統合化コンセプト」です。通常のデータセンター建設には、土地の選定から設計、建築、設備導入まで、長い時間と多大なコストがかかります。しかし、このコンテナ型データセンターは、必要な設備(サーバー、冷却装置、電源など)があらかじめコンテナ内に統合されており、現場での設置工事を大幅に削減できます。まるでレゴブロックを組み立てるように、必要な機能を備えたコンテナを配置し、連結するだけでデータセンターを構築できるイメージです。

この技術により、データセンターの建設期間を劇的に短縮し、初期投資を抑えることが可能になります。また、必要に応じてコンテナを追加することで、柔軟に規模を拡張できる「ダイナミックスケールアウト」も実現します。これは、AIの進化速度が非常に速く、必要な計算リソースが常に変化するAIインテンシブな時代において、非常に有効なアプローチと言えるでしょう。

展示ブース:最先端技術のデモンストレーション

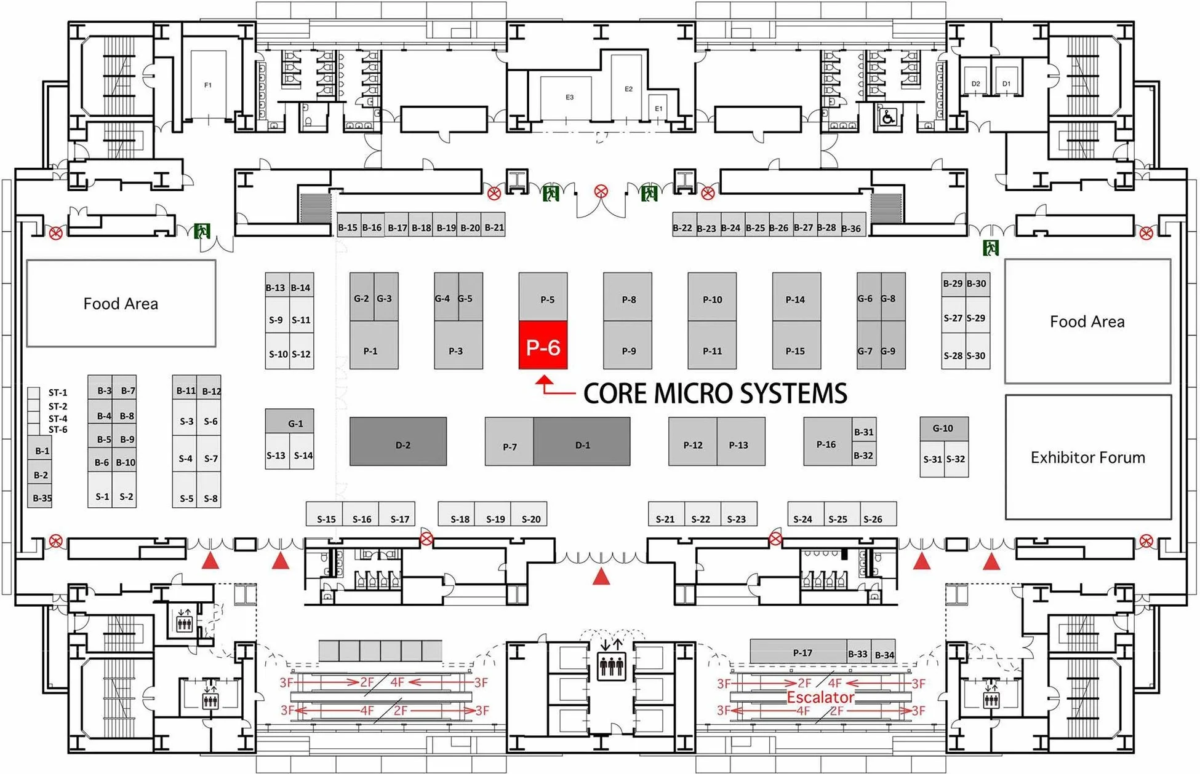

コアマイクロシステムズの展示ブース(3階、ブース番号P-6)では、発表された革新的なソリューションの具体的な姿を直接見ることができます。

ブースでは、導入設置工事を事実上不要にする「完全セルフコンテイン方式」の次世代コンテナモジュラデータセンターをベースとした、最新の統合型AI HPCプラットフォームソリューションが展示されます。

「完全セルフコンテイン方式」とは、電力受給装置と冷却装置が一体化されており、外部からの特別な工事なしに、コンテナ単体で機能が完結するシステムです。これにより、設置場所の選定から稼働までのリードタイムを大幅に短縮し、必要な場所に迅速にAI HPCインフラを展開することが可能になります。

さらに、冷却技術の進化も大きな見どころです。高性能なAIチップは非常に多くの熱を発するため、その冷却はデータセンターの安定稼働とエネルギー効率にとって極めて重要です。

-

完全空冷コンテナで500KWの冷却: 一般的な空冷システムでありながら、1つのコンテナで500キロワット(KW)もの大規模な熱を効率的に冷却できる画期的な技術が紹介されます。これは、高性能なAIサーバーを多数搭載しても、安定した温度を保つことができることを意味します。

-

DLCハイブリッド冷却や液浸冷却によりコンテナ当たり1MWの冷却: さらに進んだ冷却技術として、「DLC(Direct Liquid Cooling)ハイブリッド冷却」や「液浸冷却」が展示されます。DLCハイブリッド冷却は、サーバーの熱源に直接液体を接触させて冷却する方式と空冷を組み合わせたものです。一方、「液浸冷却」は、サーバー全体を特殊な非導電性液体に浸すことで、非常に高い冷却効率を実現する技術です。これらの先進技術により、1つのコンテナで1メガワット(MW)もの冷却が可能となり、より高密度で強力なAI HPCシステムを構築できるようになります。これは、AIの計算能力を極限まで高めるための、まさに次世代の冷却ソリューションと言えるでしょう。

これらの展示は、AIインテンシブなワークロードを支えるための、具体的なハードウェアとインフラソリューションの進展を示すものです。

コアマイクロシステムズについて

コアマイクロシステムズ株式会社は、高度なストレージ関連技術を核として、様々な高性能コンピューティングソリューションを提供する企業です。具体的には、大容量・高速・高可用性を実現するストレージサーバーシステム、AI・HPC・スーパーコンピューター向けのトータルソリューションシステム、さらには用途や特性に合わせたカスタムインテグレーション(特注のシステム構築)、ODM/OEM(他社ブランドでの製品供給)サービスまで幅広く手掛けています。

急速に進化するIT/ICT(情報通信技術)の分野において、同社は必要不可欠な高度なサーバーソリューションを開発・提供しています。次世代のデジタルトランスフォーメーション(デジタル技術による変革)を支える製品開発に積極的に取り組んでおり、AI時代のインフラをリードする存在と言えます。

同社の詳細については、以下の公式サイトをご覧ください。

https://www.cmsinc.co.jp/

イベント「SCA/HPCAsia 2026」概要

コアマイクロシステムズが革新的な発表を行う「SCA/HPCAsia 2026」の基本情報は以下の通りです。

-

名称: SCA/HPCAsia 2026

-

開催日: 2026年1月26日(月曜日)〜29日(木曜日)

-

場所: 大阪府立国際会議場(グランキューブ大阪)

このイベントは、AIとHPCの未来を展望し、最新技術に触れる貴重な機会となるでしょう。

まとめ

コアマイクロシステムズが「SCA/HPCAsia 2026」で発表する次世代AI HPCソリューションは、AIインテンシブな時代におけるスーパーコンピューティングのあり方を大きく変える可能性を秘めています。Disaggregated型システムによる柔軟性、スケールアウトによる拡張性、マルチクラウドによる最適化、そしてコンテナ型データセンターによる迅速な展開と最先端の冷却技術は、AI開発者が直面する様々な課題を解決し、AIのさらなる進化を後押しするでしょう。

これらの技術は、AIの学習効率を飛躍的に向上させ、より複雑で高度なAIモデルの開発を可能にします。これにより、医療、科学、製造業、金融など、あらゆる分野でAIが新たな価値を創造し、私たちの社会をより豊かにしていくことが期待されます。コアマイクロシステムズの取り組みは、デジタルトランスフォーメーションを加速させ、未来のコンピューティング環境を築く上で重要な一歩となるでしょう。AI初心者の方も、この機会に最先端の技術に触れ、AIがもたらす未来の可能性を感じてみてはいかがでしょうか。